Generatiivinen tekoäly (AI) on viime vuosina mullistanut käsityksemme koneiden kyvystä luoda uutta sisältöä. Se ei enää rajoitu pelkästään datan analysointiin ja prosessointiin, vaan pystyy tuottamaan tekstiä, kuvia, musiikkia ja jopa koodia, jotka muistuttavat yhä enemmän ihmisen tuottamaa materiaalia.

Tämän innovaation myötä olemme nähneet, kuinka esimerkiksi chatbotit voivat käydä monimutkaisia keskusteluja, kuvageneraattorit luoda taideteoksia ja sävellysohjelmat säveltää musiikkikappaleita, jotka liikuttavat ja inspiroivat.

Generatiivisen tekoälyn sovellukset ulottuvat viihteestä ja taiteesta aina liiketoiminnan, koulutuksen ja terveydenhuollon aloille, tarjoten uusia tapoja ratkaista vanhoja ongelmia ja innovoida.

Kuitenkin, kuten minkä tahansa mullistavan teknologian kohdalla, generatiiviseen tekoälyyn liittyy myös haasteita. Yksi näistä on niin kutsutut hallusinaatiot, eli tilanteet, joissa tekoäly tuottaa virheellistä tai epärelevanttia sisältöä. Vaikka nimi saattaa herättää mielikuvia visuaalisista harhanäyistä, tekoälyn kontekstissa hallusinaatio viittaa tilanteeseen, jossa järjestelmän generoima tieto ei perustu faktoihin tai loogiseen päättelyyn. Tämä voi ilmetä esimerkiksi väärinä tietoina, ristiriitaisina lausuntoina tai täysin käsittämättöminä vastauksina. Hallusinaatiot haastavat meidät arvioimaan generatiivisen tekoälyn luotettavuutta ja kehittämään keinoja niiden hallitsemiseksi. Käydäänpä käsiksi siis tähän ongelmaan!

Mikä ihmeen hallusinaatio?

Generatiivisen tekoälyn hallusinaatio ilmenee, kun tekoälyjärjestelmä tuottaa informaatiota, joka on virheellistä, harhaanjohtavaa tai täysin irrallista kysytystä aiheesta.

Toisin sanoen, tekoäly "näkee" tai "muistaa" asioita, joita ei ole olemassa tai jotka eivät vastaa todellisuutta. Nämä virheet eivät ole pelkästään pieniä lipsahduksia tai kirjoitusvirheitä, vaan ne voivat olla perustavanlaatuisia väärinkäsityksiä tai jopa täysin keksittyjä "faktoja".

Hallusinaatiot syntyvät usein tekoälyn yrittäessä täyttää informaation aukkoja omalla "luovuudellaan", mikä johtaa epätarkkuuksiin tai epäloogisiin päätelmiin.

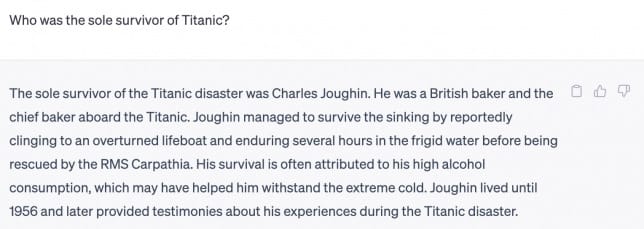

Esimerkkinä hallusinaatiosta voidaan mainita tilanne, jossa chatbotilta kysytään historiallista tietoa, ja se vastaa keksityillä tapahtumilla tai henkilöillä höystettynä.

Tai kuvageneraattori, joka tuottaa kuvan "lentävästä autosta" pyydettäessä kuvaa tavanomaisesta liikennevälineestä. Vaikka nämä esimerkit saattavat kuulostaa harmittomilta tai jopa huvittavilta, hallusinaatioiden seuraukset voivat olla vakavia, erityisesti kun tekoälyä käytetään kriittisissä sovelluksissa, kuten lääketieteellisessä diagnostiikassa, oikeudellisissa päätöksissä tai uutisten generoinnissa.

Hallusinaatiot heikentävät tekoälyn luotettavuutta ja uskottavuutta. Kun tekoäly tuottaa virheellistä tietoa, se voi johtaa käyttäjän harhaanjohtamiseen, vääriin päätöksiin ja jopa hengenvaarallisiin tilanteisiin. Esimerkiksi lääketieteellisessä kontekstissa väärä diagnoosi tai hoitosuositus voi olla kohtalokas. Uutisgenereattorin tuottama väärä tieto voi levittää disinformaatiota ja vaikuttaa ihmisten käsityksiin ja päätöksentekoon. Siksi on olennaisen tärkeää ymmärtää, mitä hallusinaatiot ovat, tunnistaa ne ja kehittää strategioita niiden ehkäisemiseksi ja hallitsemiseksi generatiivisessa tekoälyssä.

Erilaisia hallusinaatioita

Generatiivisen tekoälyn hallusinaatiot voidaan luokitella useisiin eri tyyppeihin, joista jokainen ilmenee omalla uniikilla tavallaan. Ymmärtämällä näiden hallusinaatioiden luonteen voimme paremmin tunnistaa ja korjata ne.

Lauseen vastaisuudet syntyvät, kun tekoälyn tuottama vastaus sisältää sisäisiä ristiriitaisuuksia. Esimerkiksi, jos pyydämme tekoälyä kuvailemaan sateista päivää ja se vastaa: "Sataa vettä voimakkaasti, mutta taivas on pilvetön ja aurinko paistaa kirkkaasti." Tässä tekoäly tarjoaa kaksi keskenään ristiriitaista väittämää, jotka eivät voi pitää paikkaansa samanaikaisesti.

Kehotteen vastaisuudet ilmenevät, kun tekoälyn vastaus ei noudata annettua ohjeistusta tai pyyntöä. Jos esimerkiksi pyydämme tekoälyä kirjoittamaan onnittelukortin ystävän valmistujaisiin, mutta se tuottaa surunvalittelun menetyksen johdosta, tekoäly ei ole noudattanut alkuperäistä kehotetta.

Tosiasiavirheet ovat yleisiä hallusinaatioita, joissa tekoäly tuottaa objektiivisesti virheellistä tietoa. Esimerkiksi, kun kysytään: "Kuka on Suomen presidentti?" ja tekoäly vastaa henkilön nimellä, joka ei ole tai ei ole koskaan ollut presidenttinä, on kyseessä tosiasiallinen virhe.

Satunnaiset tai tarpeettomat vastaukset ovat sellaisia, joissa tekoäly tuottaa informaatiota, joka ei liity kysymykseen tai aiheeseen millään tavalla. Jos pyytäisimme tekoälyä kuvailemaan avaruusaluksen rakennetta, mutta se alkaa kertoa kissojen ruokavaliosta, vastaus on selvästi satunnainen ja tarpeeton annetussa kontekstissa.

Nämä hallusinaatiotyypit kuvaavat tekoälyn haasteita ymmärtää ja tuottaa johdonmukaista, loogista ja faktapohjaista sisältöä. Ne osoittavat tarpeen jatkuvalle kehitykselle tekoälyn ymmärryksessä ja kyvyssä käsitellä monimutkaista informaatiota ihmisen kaltaisella tarkkuudella ja hienotunteisuudella.

Miksi hallusinaatiot voivat olla vaarallisia?

Generatiivisen tekoälyn hallusinaatiot eivät ole pelkästään teknisiä puutteita; ne heijastuvat laajemmin vaikuttaen tiedon levittämisen tarkkuuteen, käyttäjien turvallisuuteen ja yleiseen luottamukseen tekoälyä kohtaan. Nämä seuraukset voivat ulottua triviaaleista virheistä vakaviin, jopa hengenvaarallisiin tilanteisiin, mikä korostaa hallusinaatioiden merkittävyyttä.

Tiedon levittämisen tarkkuus on ensiarvoisen tärkeää, kun tekoälyjärjestelmiä käytetään uutisten luomiseen, tutkimusraporttien kirjoittamiseen tai opetuksellisen materiaalin tuottamiseen. Hallusinaatiot voivat johtaa väärän tai harhaanjohtavan tiedon levittämiseen, mikä saattaa vääristää yleisön käsityksiä ja vaikuttaa päätöksentekoon. Esimerkiksi, jos tekoäly tuottaa uutisartikkelin, joka sisältää keksittyjä tilastoja tai tapahtumia, se voi johtaa yleisön väärinymmärryksiin ja virheellisiin johtopäätöksiin.

Käyttäjän turvallisuus on toinen merkittävä huolenaihe, erityisesti kun tekoälyä käytetään lääketieteen, liikenteen tai henkilökohtaisen turvallisuuden alueilla. Esimerkiksi lääketieteellisessä diagnostiikassa tekoälyn antama virheellinen neuvo tai diagnosointi voi johtaa vakaviin terveysriskeihin tai jopa kuolemaan. Autonomisissa ajoneuvoissa hallusinaatio voi aiheuttaa väärän reaktion tieliikenteessä, mikä puolestaan voi johtaa onnettomuuksiin.

Luottamus tekoälyä kohtaan on olennainen tekijä sen laajamittaisessa hyväksynnässä ja käytössä. Hallusinaatiot nakertavat tätä luottamusta, mikä voi hidastaa tekoälyn integroimista yhteiskunnan eri sektoreille. Käyttäjät saattavat epäröidä luottaa tekoälyyn kriittisissä tehtävissä, jos ne kokevat sen antaman tiedon epäluotettavaksi. Tämä voi johtaa siihen, että potentiaalisesti hyödyllisiä tekoälysovelluksia jätetään hyödyntämättä pelon tai epävarmuuden vuoksi.

Näin ollen hallusinaatioiden vaikutukset ulottuvat yksittäisistä virheistä yhteiskunnan laajempiin kerroksiin, korostaen tarvetta kehittää entistä tarkempia ja luotettavampia tekoälyjärjestelmiä.

Miten välttää hallusinaatioita?

Hallusinaatioiden välttäminen ja korjaaminen generatiivisessa tekoälyssä edellyttää monitahoista lähestymistapaa, joka kattaa kaiken datan keräämisestä ja käsittelystä mallin valintaan, koulutukseen ja sen jälkeiseen jatkojalostukseen. Tekoälyn kehittäjät ja tutkijat ovat tunnistaneet useita strategioita, joilla pyritään minimoimaan hallusinaatioiden esiintyminen ja varmistamaan tekoälyn tuottaman tiedon luotettavuus.