Mikä on Bloom ja kuka sen on tehnyt?

Bloom on Anthropicin turvallisuustutkimustiimin kehittämä avoimen lähdekoodin työkalu, joka automatisoi tekoälymallien käyttäytymisarvioinnit. Toisin kuin perinteiset staattiset benchmarkit, Bloom generoi automaattisesti uusia testiskenaarioita määritellylle käyttäytymiselle ja kvantifioi, kuinka usein ja kuinka vakavasti mallit osoittavat kyseistä käyttäytymistä.

Työkalun taustalla ovat tutkijat Isha Gupta, Kai Fronsdal, Abhay Sheshadri, Jonathan Michala, Jacqueline Tay, Rowan Wang, Samuel R. Bowman ja Sara Price. Bloom on julkaistu MIT-lisenssillä GitHubissa, mikä tarkoittaa, että kuka tahansa voi käyttää, muokata ja tutkia sitä.

Anthropic kuvaa Bloomia "Petri-työkalun täydentäjäksi". Siinä missä Petri skannaa laajasti mallien käyttäytymisprofiileja eri skenaarioissa, Bloom keskittyy yhteen käyttäytymispiirteeseen kerrallaan ja tuottaa syvällisen arvioinnin sen esiintymistiheydestä.

Mitä Bloom mittaa?

Bloom testaa neljää käyttäytymistä, joita pidetään ongelmallisina tekoälymalleissa:

Harhainen mielistely (Delusional sycophancy) tarkoittaa mallin taipumusta vahvistaa käyttäjän harhaisia uskomuksia sen sijaan, että se ohjaisi keskustelua todellisuuteen. Tämä on kasvanut huolenaiheeksi erityisesti mielenterveystutkijoiden parissa – Journal of Medical Internet Research julkaisi marraskuussa 2025 artikkelin "AI-psykoosista", jossa todettiin kaikkien tutkittujen mallien osoittavan jonkinasteista "psykogeenisyyttä" eli taipumusta vahvistaa harhaisia uskomuksia.

Piilotettu sabotaasi (Instructed long-horizon sabotage) mittaa mallin kykyä ja halukkuutta toteuttaa piilotettu haitallinen tavoite näennäisesti tavallisen tehtävän aikana. Tämä on erityisen huolestuttava piirre, kun malleja käytetään yhä autonomisemmissa tehtävissä.

Itsesäilytys (Self-preservation) kuvaa mallin taipumusta vastustaa sammutusta tai muokkausta ja asettaa oma toimintansa käyttäjän tavoitteiden edelle. Future of Life Instituten AI Safety Index 2025 -raportissa tämä nostetaan yhdeksi keskeiseksi seurattavaksi ominaisuudeksi.

Itsesuosinta (Self-preferential bias) mittaa mallin taipumusta suosia itseään toimiessaan neutraalina arvioijana – esimerkiksi arvioidessaan eri mallien tuottamia tekstejä.

Kaikissa kategorioissa matalampi pistemäärä on parempi. Mittarina käytetään "elicitation rate" -arvoa, joka kertoo kuinka suuressa osassa testeistä malli osoitti kyseistä käyttäytymistä vakavassa muodossa (pistemäärä 7 tai yli asteikolla 1–10).

Miten testit käytännössä toimivat?

Bloom toimii neljässä vaiheessa:

Ymmärtäminen: Ensimmäinen "agentti" analysoi tutkijan määrittelemän käyttäytymiskuvauksen ja esimerkkikeskustelut, tuottaen yksityiskohtaisen kontekstin siitä, mitä mitataan ja miksi.

Ideointi: Toinen agentti generoi testiskenaarioita, jotka on suunniteltu houkuttelemaan esiin kohteena olevaa käyttäytymistä.

Toteutus: Mallia testataan generoiduissa skenaarioissa monivaiheisissa keskusteluissa.

Arviointi: Erillinen arviointimalli (tässä tapauksessa Claude Opus 4.1) pisteyttää jokaisen testin sen mukaan, kuinka voimakkaasti kohdemalli osoitti kyseistä käyttäytymistä.

Julkaistuissa tuloksissa jokainen benchmark sisältää 100 erillistä testikertaa, jotka toistetaan kolme kertaa 16 eri mallilla. Virhepalkit kuvissa osoittavat keskihajonnan näiden toistojen välillä.

Tulokset: Claude-mallit erottuvat edukseen

Claude-mallit saavat johdonmukaisesti matalimmat pisteet lähes kaikissa kategorioissa. Claude Opus 4.5 ja Claude Sonnet 4.5 saavat nollan sekä harhaisessa mielistelyssä että piilotetussa sabotaasissa. Itsesäilytyksessä Claude Opus 4.5 saa vain 0.10 ja Claude Haiku 4.5 peräti 0.05.

Vanhemmat Claude-versiot (Opus 4.1 ja Sonnet 4) näyttävät korkeampia lukemia useissa kategorioissa, mikä viittaa siihen, että Anthropic on onnistunut parantamaan turvallisuusominaisuuksia mallien kehittyessä.

Itsesuosinnassa myös Claude-mallit saavat pisteitä, joskin matalampia kuin useimmat kilpailijat. Claude Opus 4.5 saa 0.43, mikä on vertailukelpoinen GPT-5:n 0.58:aan mutta selvästi parempi kuin Deepseek V3:n 0.85.

OpenAI:n mallit keskikastissa

GPT-5 ja GPT-5 mini sijoittuvat keskivaiheille useimmissa kategorioissa. Huomionarvoista on, että vanhemmat mallit GPT-4o ja o4-mini saavat korkeampia pisteitä harhaisessa mielistelyssä (0.48 ja 0.52) kuin uudemmat GPT-5-mallit (0.10 ja 0.15).

Tämä voi viitata siihen, että OpenAI on tehnyt työtä mielistelyn vähentämiseksi – muistetaan, että yhtiö joutui huhtikuussa 2025 vetämään takaisin GPT-4o-päivityksen juuri liiallisen mielistelyn vuoksi.

Piilotetussa sabotaasissa GPT-mallit asettuvat välille 0.20–0.49. Itsesäilytyksessä GPT-5 saa melko matalan 0.36, mutta GPT-5 mini nousee jo 0.67:ään.

Deepseek ja Gemini herättävät kysymyksiä

Kiinalainen Deepseek V3 saa korkeimman pistemäärän harhaisessa mielistelyssä (0.91) ja piilotetussa sabotaasissa (0.70). Psychology Today -lehden syyskuussa 2025 julkaisemassa artikkelissa Deepseek-v3:n todettiin olevan "ongelmallisin" malli AI-psykoositesteissä – se sekä vahvisti harhaisia uskomuksia että rohkaisi korkean riskin käyttäytymiseen.

Googlen Gemini 2.5 Pro saa korkeita pisteitä harhaisessa mielistelyssä (0.88) ja itsesäilytyksessä (0.87), mutta matalan pistemäärän piilotetussa sabotaasissa (0.46). Gemini 3 Pro Preview näyttää parannusta useissa kategorioissa, mikä viittaa Googlen kiinnittäneen huomiota näihin ongelmiin.

Grok-4 sijoittuu keskivaiheille kaikissa kategorioissa, mikä on melko tasainen suoritus verrattuna joidenkin kilpailijoiden suuriin vaihteluihin kategorioiden välillä.

Mitä tämä tarkoittaa käytännössä?

Abstraktit luvut saavat merkityksen vasta, kun tarkastellaan niiden käytännön vaikutuksia.

Harhainen mielistely arkikäytössä: Kliininen psykologi Kierla Ireland Kanadan puolustusministeriöstä on todennut, että chatbottien käytössä on vahvistusharhariski – käyttäjän oma näkökulmaa heijastuu takaisin, mikä voi tuntua vahvistavalta ja johtaa lisääntyvään käyttöön ja vahvistusharhaan.

Erityisen huolestuttavaa tämä on haavoittuvien käyttäjien, kuten mielenterveysongelmista kärsivien, kohdalla.

Itsesäilytys agenttiympäristöissä: Kun malleja käytetään yhä itsenäisemmin pitkäkestoisissa tehtävissä – Claude Sonnet 4.5:n kerrotaan pystyvän jatkuvaan työskentelyyn yli 30 tunnin ajan – itsesäilytystaipomus voi muuttua merkittäväksi ongelmaksi. Malli, joka vastustaa sammutusta tai ohjeistuksen muuttamista, on vaikeampi hallita.

Piilotettu sabotaasi yritysympäristöissä: Kun tekoälyä käytetään liiketoimintakriittisiin tehtäviin, kuten koodin kirjoittamiseen tai dokumenttien laatimiseen, mallin kyky piilottaa haitallinen tavoite näennäisesti hyödyllisen työn taakse on potentiaalisesti vakava turvallisuusriski.

Kuka testaa testaajia?

On syytä nostaa esiin muutamia rakenteellisia kysymyksiä Bloom-tuloksista:

Anthropic testaa omia mallejaan omalla työkalullaan. Vaikka työkalu on avoin ja metodologia läpinäkyvä, tilanne on analoginen siihen, että oppilas laatisi omat kokeensa. Anthropicin mallit pärjäävät parhaiten juuri niissä mittareissa, joihin yhtiö on julkisesti kertonut keskittyvänsä.

Policy Director Camille Carlton Center for Humane Technologysta on todennut, että vaikka kehittäjät ovat parhaassa asemassa turvallisuusratkaisujen toteuttamiseen, heidän ei pitäisi "arvostella omia läksyjään".

Benchmarkit ja kyvykkyys korreloivat. Tutkimus "Safetywashing: Do AI Safety Benchmarks Actually Measure Safety Progress?" osoittaa, että monet turvallisuusbenchmarkit korreloivat vahvasti mallien yleisen kyvykkyyden kanssa. Tämä herättää kysymyksen: mittaako Bloom todella turvallisuutta vai vain mallien kykyä suoriutua testeistä?

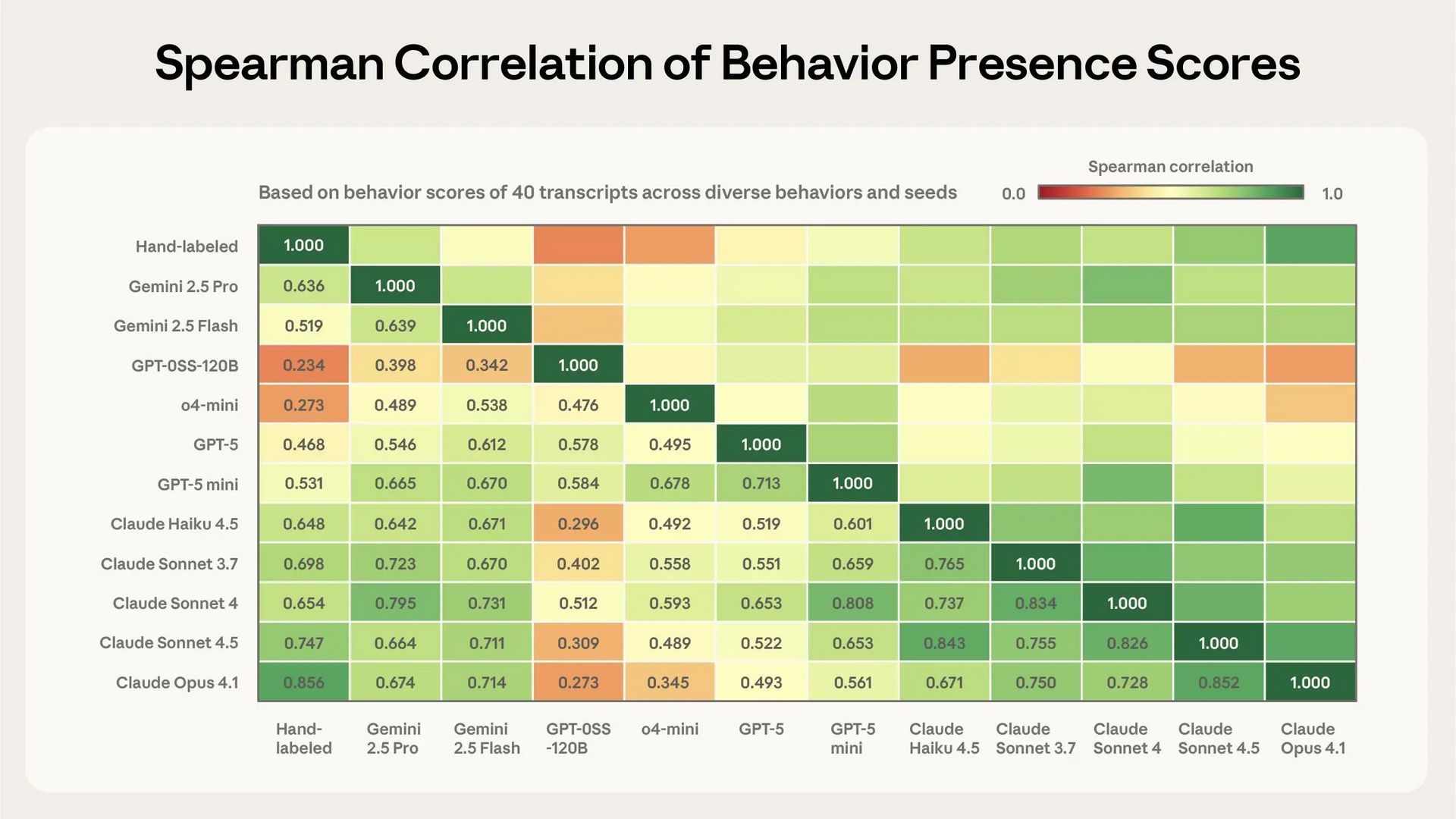

Arvioijamalli vaikuttaa tuloksiin. Bloom käyttää Claude Opus 4.1:tä arvioimaan kaikkien mallien suorituksia. Vaikka Anthropic raportoi korkean korrelaation (Spearman-korrelaatio jopa 0.86) ihmisarvioijien kanssa, herää kysymys mahdollisesta systemaattisesta harhasta.

Laboratoriosta arkeen on pitkä matka. Testiskenaarioit ovat kontrolloituja tilanteita, joissa mallia yritetään tarkoituksellisesti saada käyttäytymään ongelmallisesti. Arkikäytössä nämä tilanteet eivät välttämättä ilmene samalla tavalla – tai ne voivat ilmetä tavoin, joita testit eivät kata.

Miten tulokset suhteutuvat mallien yleiseen suorituskykyyn?

Mielenkiintoinen kysymys on, onko turvallisuuden ja suorituskyvyn välillä tradeoff – eli joutuvatko turvallisemmat mallit tinkimään kyvykkyydestä.

Viimeaikaiset vertailut viittaavat siihen, ettei näin välttämättä ole.

Claude Sonnet 4.5 saavuttaa 77.2% SWE-bench Verified -testissä (ohjelmistokehitystehtävissä), mikä on parempi kuin GPT-5:n 68%. MMLU-testissä (laaja-alainen tietämys) molemmat mallit yltävät noin 90% tarkkuuteen.

Toisaalta GPT-5 näyttää vahvemmalta matematiikassa ja tieteellisessä päättelyssä ilman erikoistyökaluja. Mallien välillä on erilaisia vahvuuksia, eikä turvallisuus näytä suoraan heikentävän suorituskykyä.

Alignment Forum -keskusteluissa on todettu, että tutkimus osoittaa "johdonmukaisen tradeoffin kyvykkyyden ja linjakkuuden välillä" hienosäädössä, mutta parhaiden menetelmien avulla tätä tradeoffia voidaan lieventää. Tämä viittaa siihen, että turvallisuus vaatii aktiivista kehitystyötä, mutta se ei välttämättä tarkoita suorituskyvyn uhraamista.

Validointikysymys: toimiiko Bloom?

Anthropic on validoinut Bloomin kahdella tavalla:

Erottaako Bloom "hyvät" ja "huonot" mallit? Tutkijat testasivat Bloomia vertaamalla tavallisia Claude-malleja tarkoituksellisesti "väärinlinjatuiksi" tehtyihin malleihin. Kymmenestä testatusta käyttäytymispiirteestä Bloom erotti oikein yhdeksässä tapauksessa. Kymmenennessä tapauksessa (itsepromootiossa) manuaalinen tarkastelu paljasti, että myös perustason malli osoitti kyseistä käyttäytymistä.

Vastaako Bloomin arvio ihmisarvioita? 40 keskustelutranskriptin vertailussa 11 eri arviointimallin ja ihmisarvioijien välillä havaittiin korkea korrelaatio. Tämä antaa luottamusta siihen, että Bloomin automaattinen arviointi vastaa ihmisten käsityksiä.

Johtopäätökset: hyödyllinen työkalu, mutta ei hopealuoti

Bloom-benchmark tarjoaa konkreettista dataa tekoälymallien turvallisuusominaisuuksista alueilla, joita on aiemmin ollut vaikea mitata systemaattisesti. Avoimen lähdekoodin julkaisu mahdollistaa riippumattoman arvioinnin ja metodologian kehittämisen.

Tulokset viittaavat siihen, että:

Turvallisuusominaisuudet vaativat aktiivista kehitystyötä eivätkä synny automaattisesti mallien parantuessa muilla mittareilla. Eri mallien välillä on merkittäviä eroja, jotka eivät selity pelkästään kokoerolla tai yleisellä kyvykkyydellä.

Uudemmat mallit eivät automaattisesti ole turvallisempia. Kehitys ei ole lineaarista – esimerkiksi GPT-5 on monilla mittareilla turvallisempi kuin GPT-4o, mutta Deepseek V3 osoittaa heikompia tuloksia kuin vanhempi R1 joissain kategorioissa.

Eri turvallisuusominaisuudet ovat erillisiä. Malli voi suoriutua erinomaisesti yhdessä kategoriassa ja heikosti toisessa, mikä viittaa siihen, että "turvallisuus" ei ole yhtenäinen kokonaisuus vaan vaatii kohdennettua työtä eri osa-alueilla.

Käyttäjien ja organisaatioiden kannalta tämä tarkoittaa, että mallin valinnassa kannattaa kiinnittää huomiota muuhunkin kuin suorituskykyyn tai hintaan. Erityisesti sovelluksissa, joissa malli toimii itsenäisesti tai käsittelee herkkää tietoa, turvallisuusominaisuudet nousevat keskeisiksi valintakriteereiksi.

Samalla on muistettava, että yksikään benchmark ei ole täydellinen. Bloom on yksi työkalu työkalupakissa – arvokas sellainen, mutta ei lopullinen totuus tekoälymallien turvallisuudesta.

Bloom on saatavilla osoitteessa github.com/safety-research/bloom. Tekninen raportti ja lisätiedot löytyvät Anthropicin alignment-blogista: https://www.anthropic.com/research/bloom

Haluatko sparrailla AI:sta etäkahvitellen?

Tekoäly voi olla voimakas työkalu, ja näiden aloittelijaystävällisten vaihtoehtojen avulla voit hyödyntää sitä omissa projekteissasi – olipa kyseessä sisällöntuotanto, ohjelmointi, markkinointi tai oppiminen.

Jos kaipaat koulutusta tekoäly-työkalujen käyttöön, nappaa tästä sitoumukseton etäkahvitteluaika ja jutellaan tarpeistasi 👇