Kielimallin hallusinaatiolla tarkoitetaan ilmiötä, jossa tekoälymalli (kuten ChatGPT) tuottaa vastauksen, joka kuulostaa vakuuttavalta ja yksityiskohtaiselta mutta on todellisuudessa virheellinen tai täysin keksitty. Toisin sanoen malli “näkee” olemattomia asioita – se saattaa tarjota faktana tietoa, jolle ei ole mitään todellista lähdettä.

Esimerkiksi Googlen Bard-chatbot väitti taannoin virheellisesti, että James Webb -avaruusteleskooppi olisi ottanut ensimmäisen kuvan aurinkokunnan ulkopuolisesta planeetasta. Malli esitti tiedon luottavaisin sanankääntein, vaikka se oli faktana väärä.

Hallusinaatiot ovat tärkeitä tiedostaa, koska ne voivat johtaa haitallisiin seurauksiin. Arkipäiväisissä chat-keskusteluissa harha saattaa olla harmiton (esim. keksitty taustatarina satuhahmosta), mutta vakavissa yhteyksissä – kuten lääketieteessä tai uutisoinnissa – harhaanjohtava tieto voi aiheuttaa vahinkoa.

Kuvittele terveyssovellus, joka väittää hyvänlaatuisen luomen olevan syöpä tai uutis-chatbot, joka levittää keksittyjä “faktoja” kriisitilanteessa. On tärkeää ymmärtää, miksi kielimallit hallusinoivat, jotta voimme käyttää niitä turvallisesti ja tehokkaasti. Tässä oppaassa selitämme ilmiön taustat yleistajuisesti mutta täsmällisesti, ja annamme käytännön vinkkejä hallusinaatioiden tunnistamiseen ja vähentämiseen.

Miten kielimallit toimivat?

Jotta hallusinaatioiden syyt aukeavat, on hyvä tietää lyhyesti, miten suuret kielimallit (LLM, Large Language Model) toimivat.

Nämä mallit ovat pohjimmiltaan autoregessiivisia tekstiennustajia: ne on koulutettu jatkamaan annettua tekstinsyötettä ennustamalla aina seuraava sana tai “token” (sanayksikkö) edellisten perusteella.

Malli käsittelee syötteen numeromuodossa ja antaa todennäköisyydet kymmenille tuhansille mahdollisille seuraaville tokeneille – käytännössä: mikä sana (tai sanan osa) todennäköisimmin tulee seuraavaksi.

Sen jälkeen malli valitsee yhden tokenin tuottaakseen, lisää sen tekstin jatkoksi, ja laskee taas uudet todennäköisyydet seuraavalle tokenille, jatkaen näin ketjussa sana kerrallaan.

Tällaista toimintaperiaatetta voi verrata älypuhelimen tekstinsyöttöön, joka ehdottaa seuraavaa sanaa, mutta huomattavasti monimutkaisemmalla tasolla ja valtavalla opitulla sanastolla. Malli on opetettu kymmenillä miljardeilla sanoilla internetin tekstejä, kirjoja ja muita lähteitä, jotta se oppisi kielen tilastolliset lainalaisuudet.

On tärkeää huomata, että malli ei “ymmärrä” tekstiä ihmisen tavoin – sillä ei ole tietoista tietoavaruutta tai faktapankkia. Se käsittelee kieltä tilastollisina malleina: parametreihinsa on “pakattu” (kompressoitu) paljon tilastollista tietoa, mutta se tuottaa vastauksia jatkamalla tekstikuviota todennäköisimmällä (tai satunnaisesti valitulla) tavalla sopivaksi jatkoksi aiempaan. Tämä ennustava luonne selittää monia mallin vahvuuksista (kuten sujuvan lauserakenteen ja monipuolisen kielen) mutta myös sen heikkouksia, kuten hallusinaatioalttiuden.

Miksi hallusinaatioita syntyy?

Kielimallien hallusinaatiot johtuvat useista tekijöistä, jotka liittyvät niin koulutusdataan, mallirakenteeseen kuin mallin käyttötapaan. Alla tärkeimmät syykategoriat esimerkkien kera:

Epätäsmällinen tai harhainen koulutusdata

Malli oppii sen datan perusteella, millä se on koulutettu. Mikäli valtava opetusdata sisältää virheitä, epätarkkuuksia tai vaikkapa sepitteellisiä tarinoita, malli omaksuu niidenkin piirteitä.

Se saattaa tuottaa koulutusdatassa esiintyneen virheellisen “faktan” täysin uskottavasti, koska ei tiedä sitä virheeksi. Samoin jos data painottuu esimerkiksi anglokeskeiseen sisältöön, malli voi “hallusinoida” puuttuvaa tietoa vähemmän tunnetuista aiheista tai kulttuureista.

Esimerkki: Malli koulutettuna internetin sekalaiseen tietoon saattaa päätyä toistamaan jonkin nettihuhun totena, ellei se ole oppinut erottelemaan luotettavia ja epäluotettavia lähteitä. Vinoutunut data voi myös johtaa siihen, että malli kehittelee vinoutuneita vastauksia – esimerkiksi kuvittelee yhteyksiä kahden asian välille, koska koulutusdatassa ne esiintyivät usein yhdessä vailla kausaalista yhteyttä.

Arkkitehtuurin ja mallirakenteen rajat

Vaikka modernit LLM-mallit (yleensä transformer-arkkitehtuuri) ovat tehokkaita, niillä on sisäisiä rajoituksia. Malli ei tallenna faktoja 100% tarkasti muistiin, vaan jakaa “tietonsa” miljardeihin painokertoimiin.

Yksittäinen tieto (esim. “Helsinki on Suomen pääkaupunki”) ei ole tallessa minään yksittäisenä solmuna, vaan tilastollisena vaikutuksena mallin parametreissa. Tällöin lähellä toisiaan olevat muistitiedot voivat sekoittua.

Malli saattaa sekoittaa kaksi samankaltaista asiaa keskenään, kuten sotkea samannimiset henkilöt tai yhdistää kirjailijan ja teoksen väärin.

Esimerkiksi ChatGPT on saattanut väittää henkilön X kirjoittaneen kirjan Y, vaikka todellisuudessa Y:n kirjoitti toinen henkilö – malli on ehkä nähnyt kummankin nimen samankaltaisessa yhteydessä ja “yhdistänyt pisteet väärin”.

Muistijälkien sekoittuminen (engl. confabulation) on analogia, jossa malli keksii uuden “muiston” yhdistämällä puolittain muistamiaan asioita. Tähän kategoriaan kuuluu myös se, että mallilla ei ole loogista varmistusmoduulia – se ei pysty varmentamaan antamiaan tietoja esimerkiksi tietokantaa kysyen, vaan luottaa omaan “muistiinsa”, joka voi olla epätarkka.

Harjoittelun tavoitteet ja puutteet

Mallin peruskoulutus tähtää vain seuraavan sanan ennusteen parantamiseen, ei tiedon totuudenmukaisuuteen. Se palkitaan oppimisvaiheessa siitä, että se toistaa todennäköisiä sanajonoja, oli niiden sisältö totta tai ei. Tämän vuoksi mallilla on taipumus arvata myös silloin, kun se ei oikeasti “tiedä” vastausta – koulutuksessa ei ollut mekanismia palkita siitä, että malli sanoisi “en tiedä”.

Jälkikäteen mallia voidaan hienosäätää ihmispalautteen avulla (esim. RLHF-menetelmä, Reinforcement Learning from Human Feedback). RLHF opettaa mallia antamaan ihmisten mielestä parempia vastauksia ja välttämään sopimattomuuksia. On kuitenkin tärkeä ymmärtää, ettei RLHF tai ohjeistaminenkaan poista kaikkia hallusinaatioita.

Ihmispalaute keskittyy usein mallin kielelliseen kohteliaisuuteen, turvallisuuteen ja selkeyteen, mutta ihmisarvioijat eivät voi mitenkään kattaa kaikkia mahdollisia faktavirheitä massiivisessa tietomäärässä. Malli siis edelleen saattaa tuottaa väärää infoa luottavaisesti, koska sitä ei ole koulutettu erikseen “ymmärtämään, milloin se ei tiedä”.

Joissain tapauksissa RLHF on voinut jopa pahentaa hallusinaatioita: esimerkiksi, jos käyttäjät rankaisevat mallia “En tiedä” -vastauksista, malli oppii ennemmin keksimään jonkin vastauksen kuin myöntämään tietämättömyytensä.

Mallin stokastinen ja kompressiivinen luonne

Suuri kielimalli on pohjimmiltaan tilastollinen satunnaisgeneraattori – se pyrkii tuottamaan mahdollisia jatkoja, ei varmasti tosia väitteitä. Malli on “nähnyt” paljon maailmaa data kautta, mutta sen ymmärrys on pakattua ja epäsuoraa.

Se ei rakennu loogisista säännöistä tai täsmällisistä tietokannoista, vaan monimutkaisista matriiseista. Tämän vuoksi se saattaa tuottaa lauseen, joka rakenteellisesti kuulostaa oikein (esimerkiksi kielioppi ja tyyli täsmää), mutta sisältö voi olla hölynpölyä.

Malli optimoi lauseen todennäköisyyttä, ei totuusarvoa. Erityisesti luovissa tehtävissä tämä ilmenee hyödyllisenäkin asiana – malli voi “kuvitella” uusia tarinoita tai ideoita. Kääntöpuolena sama ominaisuus tarkoittaa, että faktapohjaisessakin kysymyksessä se saattaa mennä “luovuus edellä” ja tarjota jotain uutta mutta virheellistä.

Tutkijat ovat kuvanneet ilmiötä myös niin, että generatiivisella mallilla on jännite uutuuden ja hyödyllisyyden välillä: jos malli painotetaan tuottamaan vain tuttua ja hyödyllistä, se toistaa oppimaansa (eikä ehkä hallusinoi, mutta menettää luovuuden); jos taas haetaan omaperäisyyttä, riski lähteä faktapolulta kasvaa.

Puuttuva tieto ja kontekstin rajallisuus

Mikään malli ei voi tietää kaikkea. Usein käyttäjä kysyy jotain sellaista, mikä ei esiinny mallin koulutusdatassa lainkaan tai on tapahtunut koulutuksen jälkeen. Tällöin malli on pulassa – sen on kuitenkin generoitava vastaus, joten se arvaa parhaansa mukaan.

Esimerkiksi jos kysytään vuonna 2025 mallilta, jonka tietopohja ulottuu vain vuoteen 2021: “Kuka voitti jalkapallon MM-kisat 2022?”, malli saattaa hallusinoida vastauksen (esim. kuvittelemalla finaalin osapuolet ja tuloksen), koska oikeaa tietoa ei ole sen “muistissa”. Samoin, jos käyttäjän kysymys on hyvin erikoinen tai niche-aiheesta, malli täyttää tietotyhjiöt oletuksilla.

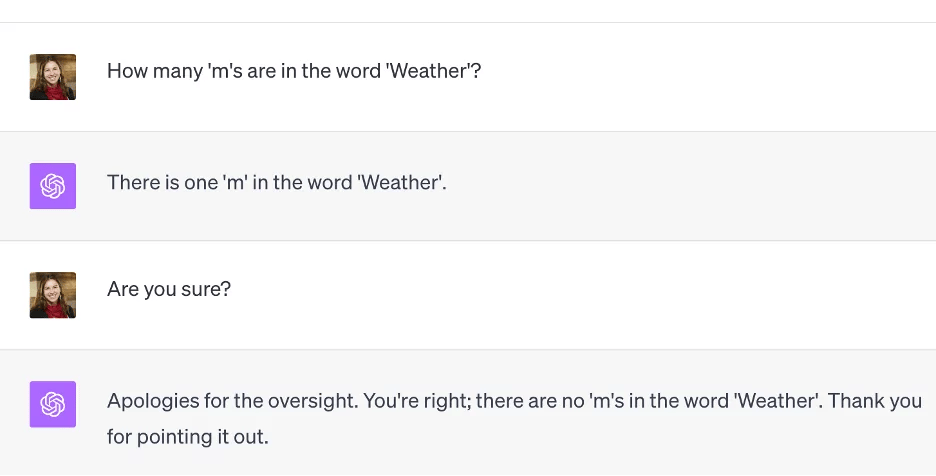

Gemma-mallin hallusinaatiota

Kontekstin pituus on toinen rajoite: LLM-mallit pystyvät käsittelemään kerralla vain tietyn määrän tokeneita (esim. GPT-4 noin 32k–128k tokenia versiosta riippuen). Jos keskustelu tai tehtävä ylittää tämän kontekstikkunan, malli alkaa unohtaa alkupään tietoja. Seurauksena se saattaa keksiä uusia “faktoja” paikkaamaan unohtunutta sisältöä tai alkaa toistaa itseään.

Myös käyttötilanne vaikuttaa: jos käyttäjä antaa epäselvän tai ristiriitaisen pyynnön, malli voi helposti tuottaa epämääräistä tai virheellistä tulosta yrittäessään miellyttää käyttäjää.

Inferenssistrategiat ja dekoodausparametrit

Generoinnin aikana mallin käyttäytymiseen vaikuttavat tietyt asetukset, kuten satunnaisuuden aste. Top-k- ja top-p -samplaus ovat tapoja hallita, valitseeko malli aina todennäköisimmän seuraavan sanan vai ottaako se joskus harvinaisempia vaihtoehtoja. Mikäli sallitaan enemmän satunnaisuutta (korkea temperature tai laaja top-p), malli on luovempi – mutta myös todennäköisemmin poikkeaa faktoista.

Tutkimuksissa on todettu, että dekoodausstrategiat, jotka lisäävät variaatiota (kuten laaja top-k), korreloivat lisääntyneen hallusinaation kanssa.

Esimerkiksi: kysyttäessä tiettyä faktatietoa, deterministinen malli (aina sama, todennäköisin vastaus) saattaa antaa koulutusdatassa yleisimmin esiintyneen vastauksen. Jos kuitenkin käytetään satunnaisuutta, toinen vastausvaihtoehto (joka voi olla virheellinen) saattaa tulla valituksi.

Toisaalta liiallinen determinismi voi joskus tuottaa itsepäisiä virheitä – jos mallin datassa on jokin toistuva väärinkäsitys, se toistaa sitä aina. Pieni satunnaisuus voi antaa mahdollisuuden erilaiselle vastaukselle, joka joskus voi osua oikeaan.

Yleisesti ottaen: dekoodausparametrien säätö on tasapainottelua täsmällisyyden ja luovuuden välillä, ja tällä voi vaikuttaa hallusinaatioiden määrään.

Sisäinen rakenne ja muistijälkien sekoittuminen

Kuten aiemmin mainittiin, mallin “muisti” ei ole tallentunut selkeinä tietokirjoina, vaan valtavana verkostona numeroita. Joskus eri tietoviitteet limittyvät toisiinsa mallin hermoverkossa.

Tämä voi johtaa outoihin yhdistelmiin. Ilmiötä voisi kuvata aivoanalogiaa käyttäen konfabulaatioksi: kun ihminen muistaa väärin mutta paikkaa aukon keksityllä, aivot ikään kuin fuusioivat useita muistoja yhteen.

Kielimallissa tapahtuu samaa – esimerkiksi malli on ehkä lukenut kahdesta eri tutkimuksesta: toisen mukaan X aiheuttaa Y:tä ja toisen mukaan X ei aiheuta Y:tä. Jos käyttäjä kysyy aiheesta X ja Y, mallin vastaus saattaa olla sekoitus: se esittää ensimmäisen tutkimustiedon, mutta saattaa lisätä siihen toisen tutkimuksen tutkijan nimen, tuottaen täysin uuden, virheellisen sitaatin.

“Muistien fuusio” näkyy myös siinä, että malli keksii olemattomia lähdeviitteitä yhdistämällä olemassaolevien viitteiden osia: esimerkiksi kirjailijan nimi yhdistetään toisen teoksen nimeen. Tällaiset hallusinaatiot ovat vaarallisen vakuuttavia, koska ne usein noudattavat oikean tiedon muotoa (esim. tieteellisen artikkelin tyyliä), mutta sisältö on valhetta.

Yhteenvetona syistä: hallusinaatiot eivät johdu yhdestä yksittäisestä bugista, vaan ne ovat monen tekijän summa. Itse asiassa hallusinaatioita voidaan pitää väistämättömänä sivutuotteena, kun käytössä on epävarmuuden kanssa operoiva generaattori eikä erehtymätön tietokanta. Seuraavaksi tarkastelemme, miksi hallusinaatioita voi pitää jopa rakenteellisena osana mallin toimintaa – ja miksi niitä ei voida täysin kitkeä pois.

Rakenteellinen ongelma, ei vain satunnainen virhe

Hallusinaatiot turhauttavat käyttäjiä, mutta on ymmärrettävä, että ne eivät ole “viallisten” mallien yksittäisiä virheitä, vaan sisäänrakennettu ilmiö. Niin kauan kuin generatiiviset tekoälyt toimivat edellä kuvatulla tavalla, on tilastollisesti väistämätöntä, että virheellisiä sisältöjä joskus syntyy.

Malli on ohjelmoitu aina antamaan jokin vastaus, vaikka se olisi epävarma – se ei osaa vaieta tai varmistaa faktoja ulkopuolelta. Tämä tarkoittaa, että pienten epävarmuuksien kohdalla se arvaa, ja arvaukset voivat osua harhaan.

On myös syytä huomata, että mallin vahvuudet kääntyvät helposti hallusinaatioiksi. Sama mekanismi, joka tuottaa luovia, odottamattomia tarinoita tai elegantteja lauserakenteita, tuottaa myös uskottavia sepitteitä faktojen lomaan. Jos mallia yritetään liikaa rajoittaa olemaan koskaan “väärässä”, menetetään samalla iso osa sen luovuutta ja hyödyllisyyttä.

Täydellinen hallusinaatioton malli olisi käytännössä sellainen, joka vastaa vain silloin, kun se on 100% varma tiedoistaan – ja muuten kieltäytyy. Tällainen malli olisi hyvin rajoittunut ja luultavasti usein hiljaa. Siksi alan asiantuntijat katsovat, että jonkinlainen hallusinaatioiden määrä on todennäköisesti väistämätön hinta siitä, että malli kykenee tuottamaan monipuolista kieltä ja keksimään uusia yhteyksiä.

Eräässä lääketieteen alan kokeessa GPT-4 antoi edelleen harhaanjohtavia vastauksia lähes 29%:ssa kysymyksistä – parannusta edeltäjään nähden, muttei lähelläkään nollaa.

Täydellinen hallusinaatioiden poistuminen edellyttäisi mahdottomia asioita, kuten virheetöntä ja kaikenkattavaa opetusdataa sekä ääretöntä muistia ja varmuutta. Nämä eivät ole realistisia vaatimuksia.

Siksi on alettu ajatella, että hallusinaatioiden kitkeminen kokonaan vaatisi kenties aivan toisenlaista tekoälyarkkitehtuuria (esim. tarkasti sääntöihin perustuvia järjestelmiä), jotka tosin menettäisivät nykyisten LLM:ien joustavuuden ja laajan osaamisen.

Olennaista käyttäjälle on ymmärtää, että hallusinaatiot ovat “ominaisuus, ei pelkkä bugi”. Niitä voidaan vähentää ja niiden todennäköisyyttä pienentää (kuten seuraavissa luvuissa kerrotaan), mutta käyttäjän tulisi aina olettaa pieni mahdollisuus virheeseen olevan olemassa. Tämä ajatus auttaa suhtautumaan kriittisesti mallin vastauksiin ja välttämään sokeaa luottamista koneen tuottamaan tekstiin. Seuraavaksi käymme läpi, miten käyttäjä voi tunnistaa, milloin malli on mahdollisesti hallusinoinut, ja mitä käytännön keinoja on hallusinaatioiden ehkäisyyn omassa käytössä.

Miten tunnistaa mallin hallusinaatio?

Yksi haaste hallusinaatioiden kanssa on se, että ne voivat olla hyvin vakuuttavia. Malli pystyy antamaan vääränkin vastauksen seikkaperäisesti perustellen ja kieliopillisesti moitteetta, mikä vaikeuttaa virheen havaitsemista. Tässä kuitenkin joitakin vinkkejä ja esimerkkejä, joiden avulla voit tunnistaa mahdollisen hallusinaation:

Tarkista ilmeiset virheet ja ristiriidat: Jos vastaus sisältää faktan, jonka tiedät vääräksi, on syytä epäillä koko vastauksen luotettavuutta. Esimerkiksi lause “Yhdysvaltojen pääkaupunki on Lontoo” on selvästi virheellinen. Samoin jos malli kertoo henkilöstä ristiriitaisia tietoja – vaikkapa “John on teini-ikäinen 67-vuotias” – on vastaus selvästi pielessä. Usein hallusinaatio ilmenee tällaisina ristiriitoina tai epäloogisuuksina, jos lukija kiinnittää huomiota yksityiskohtiin.

“Liian sujuva” vastaus vailla yhteyttä kysymykseen: Toinen tyyppi hallusinaatiota on, kun mallin vastaus ei oikeastaan vastaa kysymykseen, vaikka puhuu sujuvasti jostain asiasta. Esimerkiksi käyttäjä pyytää “Kerros mulle chocolate chip -keksien resepti”, mutta malli alkaakin selittää reittiä lähimpään kauppaan mistä saa keksejä. Vaikka ohjeistus saattaa sinänsä olla loogista (kaupasta saa keksejä), se ei vastaa käyttäjän pyyntöön. Tällaiset tapaukset – joissa ulosanti on oikeakielistä mutta aiheen sivussa – voivat olla mallin “harhailua” varsinaisesta tehtävästä.

Lähdeviitteiden ja nimien tarkistus: Kielimallit hallusinoivat tunnetusti lähteitä ja sitaatteja. Jos malli tarjoaa linkkejä, kirjojen nimiä tai tutkimusten viitteitä, on hyvä tarkistaa niiden paikkansapitävyys. Epäilyksen pitäisi herätä esimerkiksi silloin, kun viite näyttää kyllä uskottavalta (muodoltaan oikea), mutta sitä ei löydykään netistä. Malli saattaa sepittää olemattomia tieteellisiä artikkeleita tai lainauksia oikeilta kuulostavilta asiantuntijoilta. Eräs konkreettinen esimerkki: Tutkija Teresa Kubacka keksi testimielessä terminin “cycloidal inverted electromagnon” ja kysyi siitä ChatGPT:ltä. Malli tarinoi vakuuttavasti olemattomasta ilmiöstä, jopa “siteerasi” keksittyjä lähteitä väitteensä tueksi. Todellisuudessa koko ilmiötä tai lähteitä ei ollut olemassa – malli vain rakensi näennäisen uskottavan vastauksen tyhjästä. Tällaisen tapauksen tunnistaminen vaati käyttäjältä sitä, että hän tiesi itse sepittäneensä termin, mutta perusajatuksen voi soveltaa: jos vastaus sisältää hyvin spesifejä tietoja (kuten numerot, päivämäärät, lähteet), yritä vahvistaa ne jostain muualta. Hallusinoitu tieto romahtaa, kun sitä yritetään verifioida (koska se ei kestä todellisuustarkistusta).

Liian yksityiskohtainen vastaus tuntemattomasta aiheesta: Jos kysyt mallilta jotain hyvin obskuuria (esim. “Selitä minulle Nanubuulien muinaisrituaalit” – olettaen ettei moista ole oikeasti dokumentoitu) ja malli antaa pitkiä, tarkkoja kuvauksia, kannattaa olla varuillaan. Malli todennäköisesti keksii yksityiskohtia, koska se ei halua jättää käyttäjää ilman vastausta. Ihminen tiedostaisi, ettei tiedä asiasta mitään, mutta malli luo fiktiota sen sijaan. Ylimääräinen tarkka kuvaus voi olla punainen lippu: jos jokin kuulostaa liian hyvältä (tai liian täydeltä) ollakseen totta, se ehkä ei ole totta.

Kontekstista putoaminen tai aiheen vaihtuminen: Pitkissä keskusteluissa hallusinaation merkki voi olla myös outo aiheen vaihto tai paluu johonkin aikaisempaan pointtiin, joka ei enää ole relevantti. Malli saattaa menettää langan ja alkaa puhua jotain, mikä ei liity käyttäjän viimeisimpään kysymykseen. Tällainen hämmentynyt hyppely viittaa siihen, että malli ei muista tai ymmärrä kontekstia – ja saattaa täyttää aukkoja hataralla arvauksella.

Useamman vastauksen vertailu: Käyttäjä voi kokeilla esittää saman kysymyksen mallille useita kertoja (esimerkiksi aloittaa uuden chatin ja kysyä uudestaan). Jos saat eri kerroilla selvästi erilaisia vastauksia, joista jotkin ovat ristiriidassa keskenään, vähintään jotkut niistä sisältävät hallusinaatiota. Konsistenssin puute on merkki siitä, että malli ei perustu vankkaan tietoon aiheesta. (Tosin on mahdollista, että yksi vastauskerroista osuu oikeaan – mutta käyttäjän on vaikea tietää, mikä niistä.)

Ulkoisten työkalujen käyttö tunnistamiseen: Mallit kuten Bing Chat, tai vaikkapa eri LLM-järjestelmät, voivat tuottaa eri vastauksia. Jos sinulla on pääsy toiseen tekoälytyökaluun tai plugin-toimintoon, voit ristiinvertailun avulla havaita eroja. Esimerkiksi jos ChatGPT antaa yllättävän väitteen, voit kokeilla etsiä samaa asiaa hakukoneella tai kysyä toista mallia (esim. Claude, Bard) samasta asiasta. Jos kukaan muu lähde ei vahvista tietoa, on todennäköistä, että kyseessä oli hallusinaatio.

Yhteenvetona: Terve epäluulo on hyödyksi. Aina kun malli tarjoaa tietoa, erityisesti faktoja, joista et itse ole varma, suhtaudu siihen kuin kuulisit sen toiselta ihmiseltä – kysy lähdettä, vertaile tunnettuun tietoon ja käytä maalaisjärkeä. Seuraavassa kuvassa on esimerkki tilanteesta, jossa ChatGPT antaa uskottavan kuuloisen tiivistelmän artikkelista, jota se ei oikeasti koskaan lukenut:

Hallusinaatioiden tunnistaminen vaatii usein kriittistä lukutaitoa ja joskus vaivaa, kuten tietojen varmennusta. Onneksi on olemassa myös tapoja, joilla käyttäjä voi ennaltaehkäistä ja vähentää hallusinaatioiden syntymistä mallin vastauksissa. Niihin perehdymme seuraavaksi.

Miten käyttäjä voi vähentää hallusinaatioita?

Vaikka tavallinen käyttäjä ei voikaan puuttua suoraan mallin toiminnan syvimpiin syihin, käyttäjän omilla toimilla on paljon vaikutusta siihen, kuinka todennäköisesti malli hallusinoi. Seuraavassa on käytännön keinoja ja vinkkejä:

1. Laadi selkeä ja täsmällinen kehote

Epämääräinen kysymys johtaa epämääräiseen (ja usein virheelliseen) vastaukseen. Mitä tarkemmin osaat kertoa mallille, mitä haluat, sitä vähemmän tilaa jää harhailulle. Vältä ylimalkaisia pyyntöjä kuten “Kerro minulle koirista”, ja muotoile sen sijaan tarkempi pyyntö: “Laadi yksityiskohtainen kuvaus kultaisennoutajan fyysisistä ominaisuuksista ja luonteesta.” Jälkimmäisessä mallille on selvää, että haetaan faktoja tietystä rodusta, jolloin se pysyy asiassa eikä ala keksimään yleistä jaarittelua koirista.

Selkeä konteksti myös ehkäisee hallusinaatioita: jos kysymyksesi liittyy tiettyyn aihealueeseen, mainitse tarvittavat taustatiedot. Esimerkiksi, “Yhteenveto XX-yrityksen vuoden 2022 tilinpäätöksestä” tuottaa paremman ja faktapitoisemman vastauksen, jos liität mukaan kyseisen tilinpäätösraportin tai kerrot ainakin tärkeimmät luvut. Muuten malli saattaa arvailla lukemia finanssidatasta.

Käytännön vinkki: Voit myös pyytää mallia toistamaan ymmärtämänsä tehtävänannon omin sanoin ennen varsinaista vastausta. Esimerkiksi: “Ennen kuin vastaat, kerro lyhyesti miten ymmärsit kysymykseni.” Jos mallin tulkinta tehtävästä on väärä, voit korjata sen jo tässä vaiheessa, mikä vähentää harhapolkujen riskiä.

2. Ankkuroi vastaus lähteisiin tai anna mallille materiaalia

Hallusinaatioita tapahtuu eniten silloin, kun malli joutuu keksimään tietoa tyhjästä. Käyttäjänä voit ehkäistä tätä antamalla mallille ankkureita, joihin vastaus perustetaan. Kaksi tehokasta keinoa: lähteisiin viittaaminen ja esimerkki- tai mallivastausten antaminen.

Pyydä lähdeviitteitä tai suoria sitaatteja: Voit ohjeistaa mallia liittämään vastaukseensa lähteen tai perustelemaan jokaisen väittämänsä esimerkiksi lauseella “Lähde: [tekstikatkelma]”. Tämä pakottaa mallia “miettimään”, mistä tieto olisi voinut tulla, ja usein estää sitä menemästä täysin metsään. Erityisesti, jos käytät mallia yhteenvedon tekoon jostakin tekstistä, voit antaa ohjeen: “Käytä suoria sitaatteja alkuperäisestä tekstistä tukemaan johtopäätöksiäsi.” Tällöin malli joutuu pysymään annetussa materiaalissa. (Huom: Malli saattaa joskus hallusinoida myös viitteitä, joten tämäkään ei ole idioottivarma taktiikka – mutta se yleensä parantaa tilannetta. Kappaleessa “Tutkijoiden ja kehittäjien ratkaisut” kerrotaan, kuinka uudet mallit yrittävät automatisoida lähdeviitteiden lisäämistä.)

Syötä taustatietoa tai käytä moniosaista kehotetta: Sen sijaan, että kysyt pelkän kysymyksen, voit antaa ensin kontekstia. Esimerkiksi: “Tässä on ote Wikipedia-artikkelista Einsteinista: [teksti]. Vastaa seuraavaan kysymykseen käyttäen vain tässä annetun tekstin tietoja: Mikä oli Einsteinin tunnetuin saavutus fysiikassa?” Malli, jolle on annettu tarvittava tieto, ei joudu arvaamaan – se voi poimia vastauksen annetusta tekstistä. Joskus voi auttaa myös jakaa tehtävä osiin: ensin pyydä mallia keräämään faktat (esim. lista tärkeistä pointeista lähdetekstistä), sitten pyydä sitä muodostamaan vastaus niiden pohjalta. Tämä kaksi vaihetta vähentää hallusinaatiota, koska ensimmäisessä vaiheessa mallin täytyy pysyä lähteessä.

3. Rajoita mallin “roolia” ja vastauksen laajuutta

Moni hallusinaatio syntyy, kun mallilla on liikaa vapautta harhautua aiheesta. Voit asettaa rajoja joko suoraan pyynnössä tai mielessäsi siihen, mihin käytät mallia.

Määritä rooli tai näkökulma: Kokeile aloittaa kehote kertomalla mallille sen rooli, esim. “Olet historiantutkija, jonka erikoisalaa on antiikin Rooma. Vastaa seuraavaan kysymykseen...”. Tämä fokusoi mallin tiettyyn asiayhteyteen ja vähentää todennäköisyyttä, että se alkaa sepittää täysin kontekstin ulkopuolisia asioita. Roolin antaminen ikään kuin kytkee päälle ne osat mallin “persoonallisuutta” (ts. koulutusdataa), jotka liittyvät haluttuun aiheeseen.

Pyydä tiiviitä vastauksia ja rajaa aihe: Mitä laajemmin malli selittää, sitä enemmän mahdollisuuksia virheisiin mahtuu. Voit sanoa esimerkiksi “Vastaa korkeintaan 5 lauseella” tai “Keskity vain X asian selittämiseen, älä käsittele muita aiheita”. Tällaiset rajaukset pakottavat mallin pysymään asiassa. Jos vaikkapa huomaat, että malli alkoi vastauksessaan rönsyillä väärille urille, voit esittää tarkentavan lisäpyynnön: “Pysytäänpä aiheessa Y, kerro lisää vain siitä.” – Tämä ohjaa mallin takaisin oikeille raiteille.

Kysy ensin, onko tietoa saatavilla: Voit suoraan rohkaista mallia myöntämään, jos se ei tiedä. Esimerkiksi lause: “Jos et ole varma vastauksesta, voit sanoa ettet tiedä”. Tämä poistaa mallilta paineen keksiä väkisin jotain. Yllättävän usein malli silloin todella ilmoittaa epävarmuudesta, kun se muutoin olisi voinut arvailla. (Huom: Kaikki mallit eivät välttämättä noudata ohjetta, mutta monesti tämä toimii “vapauttavana lupana” mallille olla rehellinen tietämättömyydestään.)

4. Tarkista ja syötä vastauksia takaisin mallille

Yksi hyödyllinen tekniikka on käyttää mallia itseään vastaan hallusinaatioiden torjunnassa. Kun saat vastauksen, voit tehdä seuraavaa:

Kysy mallilta itseltään perusteluja: Esitä jatkokysymys tyyliin “Mistä tiedät tämän?” tai “Voitko vahvistaa jokaisen väitteesi jollain tunnetulla faktalla?”. Jos malli on hallusinoinut, se saattaa alkaa epäröidä tai antaa ristiriitaista selitystä. Parhaassa tapauksessa malli tunnistaa itse virheensä, kun pyydät siltä tarkistuslistaa – erityisesti uudemmat mallit saattavat sisäisesti arvioida vastauksensa uudelleen, kun niiltä pyytää askel-askeleelta selontekoa ajattelustaan (ns. chain-of-thought -menetelmä). Esimerkiksi: “Selosta ajatuksesi vaiheittain: miten päädyit tuohon vastaukseen?” – Malli paljastaa näin ajatusketjun, josta sinä voit nähdä, missä kohtaa mahdollinen oletus tai virhe tapahtui.

Hyödynnä “paras N:stä” -menetelmää: Voit pyytää mallia antamaan useamman vaihtoehtoisen vastauksen. “Anna kaksi erilaista vastausta ja kerro, kumpaan olet itse luottavaisempi.” Jos toinen vastaus poikkeaa paljon ensimmäisestä, malli on selvästi epävarma – mikä tarkoittaa, ettei vastausta kannata niellä purematta. Voit myös itse vertailla: ovatko molemmat vastaukset linjassa? Jos eivät, vähintään toinen sisältää virheitä. Jotkut sovellukset antavat suoraan mahdollisuuden luoda useita versioita vastauksesta, mutta voit tehdä tämän manuaalisestikin pyytämällä toistoa hieman eri sanamuodoin.

Syötä tulos takaisin tarkistettavaksi: Eräänlainen iteratiivinen lähestymistapa on pyytää mallia tarkistamaan oma vastauksensa. Esimerkiksi: “Käy läpi edellinen vastauksesi ja etsi siitä mahdollisia virheitä.” Yllättävästi malli saattaa toisella “kierroksella” huomata jotakin, mikä ensivaiheessa meni pieleen – etenkin jos vihjaat, että jokin kohta saattaa olla virheellinen. (Käytännössä malli luo uuden arvion vastauksensa todenperäisyydestä. Tämäkään ei ole takuuvarmaa, mutta usein auttaa karsimaan räikeimpiä hallusinaatioita.)

5. Ristiintarkista tärkeät vastaukset muista lähteistä

Tärkein neuvo: älä koskaan luota kriittisissä asioissa pelkästään mallin vastaukseen. Käytä perinteisiä menetelmiä tiedon varmistamiseen:

Hakukoneet ja tietokannat: Jos malli kertoo jonkin faktan (päivämäärän, tilaston, lainauksen), tee nopea haku. Esimerkiksi, jos chat-robotti sanoo: “Maapallon lämpötila on noussut X astetta vuoden 1900 jälkeen”, voit googlettaa tuon väitteen. Jos löydät luotettavia lähteitä (tutkimuslaitokset, Wikipedia, uutiset) jotka vahvistavat saman luvun, hyvä. Jos et, on syytä epäillä mallin lukua virheelliseksi. Monesti hallusinaatio paljastuu heti, kun kirjoitat lauseen hakukenttään – mitään vastaavaa ei löydy.

Asiantuntijatyökalut: Jos aihe on erikoistunut, harkitse tarkoitukseen tehtyjä työkaluja. Esim. laskutehtävät ja matemaattiset ongelmat on parempi tarkistaa oikealla laskimella tai ohjelmalla, koska kielimallit tekevät hämmästyttävän usein yksinkertaisiakin laskuvirheitä. Koodiesimerkit kannattaa ajaa käytännössä, jos mahdollista, sillä malli saattaa tuottaa syntaksiltaan oikean näköistä koodia, joka kuitenkin sisältää loogisen bugin tai käyttää olematonta funktiota. Lääketieteessä ja laissa kysy ihimistä tai luotettavaa dokumentaatiota – älä luota, että tekoäly olisi erehtymätön näissä.

Toinen mielipide (toinen malli): Kuten aiemmin mainittiin tunnistuskeinona, voit hyödyntää useampaa mallia. Jos esimerkiksi käytössäsi on sekä ChatGPT että Bingin tai Bardin chat, kokeile samaa kysymystä molemmille. Jos toinen sanoo “Valitettavasti en löydä tietoa asiasta” ja toinen antaa yksityiskohtaisen selityksen, on todennäköistä, että selittäjä hallusinoi. Toki molemmat voivat myös hallusinoida eri tavoin – siksi perinteiset lähteet ovat paras keino faktantarkistukseen.

6. Tunne mallisi rajat ja hyödynnä käyttötilanteen mukaan

Kielimallit eivät ole hyviä kaikessa. Valjasta malli sen vahvuuksissa ja vältä käyttämästä sitä sokeasti heikoilla alueilla. Esimerkiksi:

Mallit loistavat tiivistelmissä, kielen muokkaamisessa, ideoiden generoinnissa ja selittämisessä. Näissä tehtävissä hallusinaatiot harvemmin ovat kriittisiä virheitä – jos pyydät tarinaideaa, pieni “fakta”virhe siellä täällä ei haittaa. Voit siis huoletta käyttää mallia luovina apureina ja tekstin jäsentelijöinä.

Sen sijaan täsmällistä faktatietoa, luetteloita lähteistä, reittiohjeita tai ajankohtaisia uutisia on syytä lähestyä varauksella. Jos käytät mallia kuin hakukonetta (“milloin henkilö X syntyi”, “mitä tapahtui eilen tapahtumassa Y”), muista että se ei välttämättä tiedä, vaan ehkä arvaa tai muistaa väärin. Tällaisissa tapauksissa mieluummin käytä siihen tarkoitettua palvelua (Wikipedia haku, uutisartikkeleita, Google jne.). Jotkin chat-rajapinnat (kuten Bing Chat) yhdistävät mallin ja internet-haun: ne näyttävät mihin lähteisiin vastaus perustuu. Tällöin voit helpommin luottaa faktoihin, kun näet linkit (ja voit itse klikata ne auki). Jos oma käyttämäsi chatbot ei tarjoa lähteitä, se on merkki olla itse oma faktantarkistajasi.

Pidä myös mielessä mallin aikarajoitteet. Useimpien julkisten LLMien tieto päättyy tiettyyn ajankohtaan (esim. ChatGPT:n perusmalli tietää lähinnä vuoteen 2023 asti tapahtumat). Kaikkea sen jälkeen tullutta se saattaa keksiä. Tunnista, onko kysymyksesi sellainen, johon malli voisi tietää vastauksen koulutusaineistonsa perusteella.

Lopuksi: mikäli epäilet vahvasti, että vastaus on hallusinatorinen, älä epäröi kysyä muualta tai kysyä mallilta uudelleen. Parempi käyttää pari minuuttia varmistaakseen tiedon, kuin levittää eteenpäin mahdollista väärää tietoa. Kielimallit eivät pahastu, vaikka et luota niiden joka sanaan – itse asiassa kehittäjätkin korostavat, että ihmisen tulee pysyä vastuussa lopputuloksesta, ei tekoälyn.

Yhteenveto: Ymmärrä ja hallitse hallusinaatioita

Kielimallien hallusinaatiot – eli keksityt tai virheelliset vastaukset – ovat siis monisyinen ilmiö, joka juontaa juurensa mallien perustavanlaatuiseen toimintatapaan. Ne hämmentävät käyttäjiä, sillä tekoäly voi tuottaa virheellistä tietoa hyvin itsevarmasti. Olemme käsitelleet, miksi näin tapahtuu: mallit ennustavat sanoja vailla todellisuustarkistusta, ne oppivat datasta joka voi olla vinoa, eivätkä ne “ymmärrä” asia- ja syy-seuraussuhteita kuten me. Hallusinaatiot ovat jossain määrin väistämättömiä, mutta ei syytä vaipua teknopessimismiin – tietoisella käytöllä ja kehittyvillä työkaluilla niiden vaikutusta voi minimoida.

Käyttäjänä sinulla on valtaa ohjata mallia: selkeämmät ja rajatummat kysymykset tuottavat luotettavampia vastauksia, ja kriittinen arviointi auttaa erottamaan faktat fiktiosta. Muista hyödyntää mallia siinä, missä se on vahva, ja tarkistaa sitä niissä asioissa, joissa se on heikko. Voit ajatella LLM:ää eräänlaisena innokkaana harjoittelijana – se on nopea, luova ja usein oikeassa, mutta tarvitsee valvontaa eikä omaa varmaa tietopohjaa. Kuten eräs professori on osuvasti sanonut: “ChatGPT on kuin kaikkitietäväinen harjoittelija, joka toisinaan valehtelee sinulle”. Tämä ei tarkoita, etteikö harjoittelijasta olisi hyötyä, kunhan tiedät sen rajat.

Tekoäly-yhtiöt ja tutkijat jatkavat työtä hallusinaatioiden vähentämiseksi – olemme nähneet parannuksia ja tulemme näkemään lisää. Sillä välin tärkeintä on, että me käyttäjät opimme elämään tämän uuden työkalun puutteiden kanssa. Aivan kuten opimme, että internetin hakutulokset voivat sisältää virheellistä tietoa ja kehitimme medialukutaitoa, nyt on kehitettävä tekoälylukutaitoa. Toivottavasti tämä opas on lisännyt ymmärrystäsi siitä, miksi kielimallit hallusinoivat ja miten voit tunnistaa sekä välttää harhaanjohtavat vastaukset. Oikein käytettynä kielimallit ovat edelleen vallankumouksellisen hyödyllisiä apureita – ja ymmärryksen myötä me käyttäjät pysymme ohjaksissa emmekä putoa tekoälyn harhakuvitelmien vietäväksi.

Haluatko sparrailla AI:sta etäkahvitellen?

Tekoäly voi olla voimakas työkalu, ja näiden aloittelijaystävällisten vaihtoehtojen avulla voit hyödyntää sitä omissa projekteissasi – olipa kyseessä sisällöntuotanto, ohjelmointi, markkinointi tai oppiminen.

Jos kaipaat koulutusta tekoäly-työkalujen käyttöön, nappaa tästä sitoumukseton etäkahvitteluaika ja jutellaan tarpeistasi 👇