Tekoälyteknologian kehityksessä kielimallien rooli on tunnustettu merkittäväksi ja ChatGPT:n myötä niiden käyttö on kasvanut räjähdysmaisest. Suuret kielimallit (LLM), kuten GPT-3 ja BERT, ovat osoittaneet vaikuttavan kykynsä monenlaisissa tehtävissä, aina luonnollisen kielen ymmärtämisestä monimutkaiseen ongelmanratkaisuun.

Näiden mallien valtavasta tietomäärästä ja monipuolisista käyttömahdollisuuksista huolimatta on kuitenkin havaittu, että ne tuovat mukanaan merkittäviä haasteita. Näihin kuuluvat niiden ylläpidon monimutkaisuus, korkeat kustannukset ja suuret vaatimukset infrastruktuurille.

Toisaalta pienet kielimallit (SLM) ovat alkaneet saada ansaitsemaansa huomiota niiden tarjoamien ratkaisujen myötä. Niiden yksinkertaisemman rakenteen ja pienemmän koon ansiosta ne ovat helpommin ylläpidettäviä ja voidaan vaivattomasti integroida ohjelmistoihin sekä verkkosovelluksiin. Tämä avaa ovia niiden laajemmalle soveltamiselle käytännön sovelluksissa, kuten chatboteissa, ääniavustajissa ja hakukoneissa.

Tässä artikkelissa syvennytään pieniin kielimalleihin, niiden etuihin verrattuna suuriin kielimalleihin ja tutkitaan, miten ne voivat muovata tekoälyn tulevaisuutta.

Haluatko pysyä kärryillä AI-maailman tapahtumissa?

Nappaa itsellesi ilmainen AI-Sanomien viikkotilaus. Se tarjoilee sinulle joka perjantai AI-alan parhaat innovaatioita, mielenkiintoisimmat uutiset, uudet työkalut, ja paljon muuta.

Pienten kielimallien ylivertaisuus

Pienten kielimallien kehityksessä on tunnistettu useita etuja, jotka tekevät niistä houkuttelevan vaihtoehdon verrattuna niiden suurempiin vastineisiin. Yksi merkittävimmistä eduista on niiden yksinkertaisempi rakenne, joka mahdollistaa helpomman ylläpidettävyyden. Suurten kielimallien monimutkaisuus ja suuret datavaatimukset asettavat paineita sekä taloudellisille että teknisille resursseille, kun taas pienempien mallien kohdalla näitä haasteita esiintyy vähemmässä määrin.

Tämä tekee pienistä malleista ihanteellisia sovelluksiin, joissa resurssien tehokas käyttö on avainasemassa.

Lisäksi pienet kielimallit voidaan integroida sujuvasti ohjelmistoihin ja verkkosovelluksiin ilman, että tarvitaan laajaa infrastruktuuria niiden tueksi. Tämä integroitavuus avaa uusia mahdollisuuksia kehittäjille ja yrityksille, jotka pyrkivät hyödyntämään tekoälyä tuotteissaan ja palveluissaan.

Erityisesti kun otetaan huomioon pienempien mallien kyky toimia tehokkaasti rajoitetummilla laitteilla, kuten älypuhelimilla ja tableteilla, niiden soveltuvuus kuluttajasovelluksiin korostuu.

Pienempien mallien toinen merkittävä etu on niiden kyky tarjota tasapaino suorituskyvyn ja resurssien käytön välillä. Vaikka suuret mallit voivat hallita laajempia ja monimutkaisempia tehtäviä, pienet mallit tarjoavat kustannustehokkaan ratkaisun sovelluksiin, joissa ei vaadita äärimmäistä monipuolisuutta.

Tämä tasapaino tekee pienistä kielimalleista erinomaisen valinnan käytännön sovelluksiin, joissa nopeus, tarkkuus ja resurssitehokkuus ovat keskeisiä vaatimuksia.

Näiden etujen valossa pienet kielimallit eivät ainoastaan tarjoa vaihtoehtoa suurille malleille, vaan ne voivat myös olla ratkaisevassa roolissa tekoälyn tulevaisuuden muovaamisessa. Niiden yksinkertaisuus, integroitavuus ja tehokkuus avaavat uusia mahdollisuuksia tekoälyn soveltamiseen, mikä voi edistää sen laajempaa hyväksyntää ja käyttöönottoa eri aloilla.

Muutamia esimerkkejä pienistä kielimalleista

Markkinoilla on nähtävissä useita tunnettuja pieniä kielimalleja, jotka ovat osoittaneet merkittävää potentiaalia erilaisissa käyttötarkoituksissa. Esimerkiksi NVIDIA:n Chat with RTX, Meta:n Llama-mallit ja RAG:n (Retrieval Augmented Generation) yhdistäminen pieniin kielimalleihin ovat kaikki esimerkkejä innovaatioista, jotka tuovat tekoälyn hyödyt suuremman yleisön ulottuville.

NVIDIA:n Chat with RTX on suunniteltu hyödyntämään yrityksen vahvaa asemaa grafiikkaprosessoriteknologiassa tarjoamalla nopeaa ja tehokasta kieliprosessointia, joka on optimoitu toimimaan reaaliaikaisissa keskustelusovelluksissa. Tämän mallin avulla voidaan tuottaa luonnollisen kuuloista dialogia minimaalisella viiveellä, mikä tekee siitä ihanteellisen ratkaisun pelien kehitykseen, virtuaaliavustajiin ja muihin interaktiivisiin sovelluksiin.

Toisaalta Meta on tuonut markkinoille Llama-mallit, jotka ovat saaneet huomiota kyvyllään käsitellä luonnollista kieltä ja tuottaa informatiivista sisältöä pienemmillä resurssivaatimuksilla.

Llama-mallien avulla kehittäjät voivat luoda kustannustehokkaita ratkaisuja, jotka eivät vaadi suurten mallien tarjoamaa laskentatehoa, mikä tekee niistä sopivia mobiilisovelluksiin ja kevyempiin web-palveluihin.

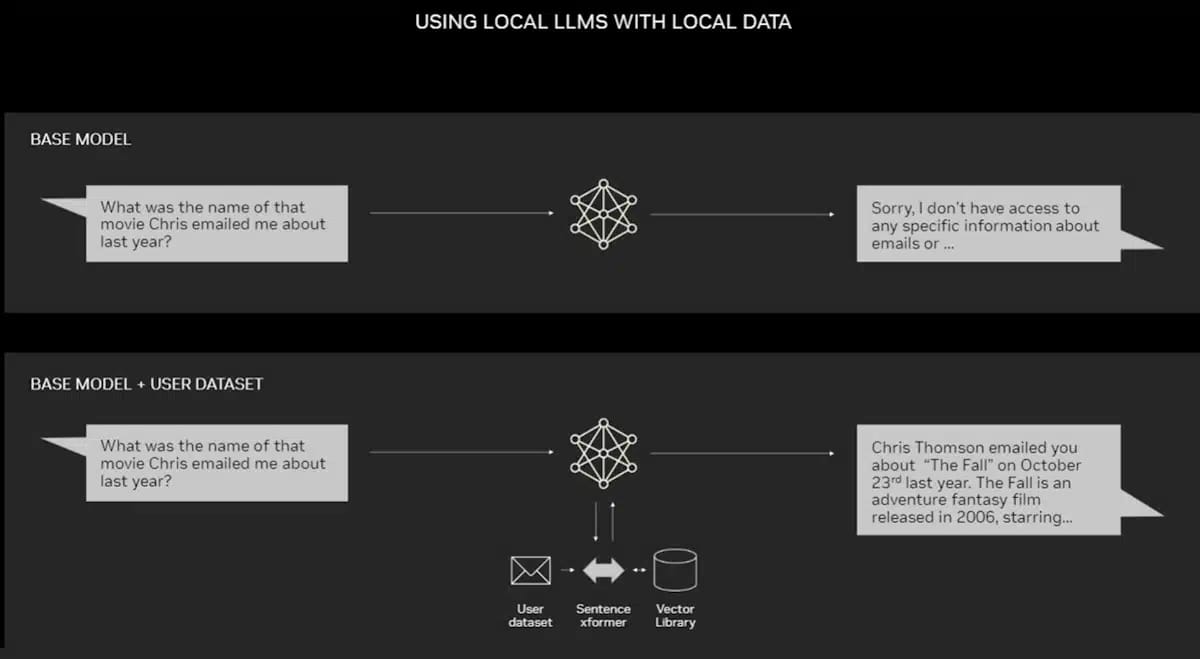

Retrieval Augmented Generation (RAG) -mallien yhdistäminen pieniin kielimalleihin edustaa toista lähestymistapaa, jossa hyödynnetään sekä kielimallien generatiivisia kykyjä että ulkoisten tietolähteiden tarjoamaa kontekstuaalista tietoa. Tämä mahdollistaa entistä tarkemman ja kontekstuaalisesti relevantin sisällön tuottamisen, mikä on erityisen hyödyllistä tiedonhakusovelluksissa ja asiakaspalveluboteissa.

Nämä esimerkit tunnetuista pienistä kielimalleista osoittavat, kuinka ala on kehittymässä kohti tehokkaampia ja resurssitehokkaampia ratkaisuja. Teknologian edistyessä on odotettavissa, että pienet kielimallit tulevat yhä tärkeämmäksi osaksi tekoälyn ekosysteemiä, mahdollistaen uusia sovelluksia ja palveluita, jotka olivat aiemmin saavuttamattomissa suurten mallien rajoitusten vuoksi.

Retrieval Augmented Generation (RAG) -mallien ymmärtäminen

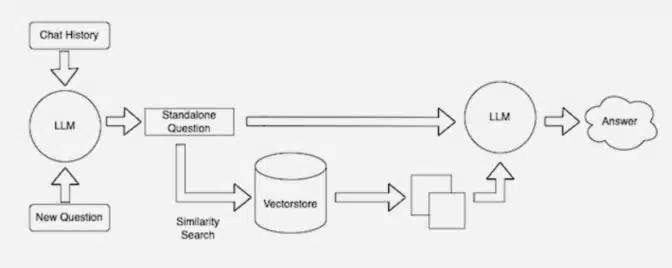

Retrieval Augmented Generation (RAG) edustaa kiehtovaa edistysaskelta tekoälyteknologiassa, erityisesti pieniä kielimalleja käsiteltäessä. RAG yhdistää perinteisen generatiivisen kielimallin kyvyt tietokantojen hakutoimintoihin, mikä mahdollistaa aiempaa tarkemman ja kontekstuaalisesti rikkaamman sisällön tuottamisen.

Tämän menetelmän avulla kielimallit eivät ainoastaan generoi tekstiä oppimiensa tietojen perusteella, vaan ne voivat myös hyödyntää ulkoisia tietolähteitä vastaustensa tueksi ja rikastamiseksi.

RAG-menetelmä toimii kahdessa vaiheessa: ensin hakukanava ("retrieval") etsii relevanttia tietoa suuresta tietokannasta tai dokumenttikokoelmasta kyselyn perusteella.

Tämän jälkeen generatiivinen kielimalli ottaa tämän tiedon ja tuottaa yhtenäisen, ymmärrettävän vastauksen, joka hyödyntää sekä mallin sisäistä tietämystä että haettua ulkoista tietoa. Tämä prosessi mahdollistaa monimutkaisten kysymysten ymmärtämisen ja niihin vastaamisen tavalla, joka on aiempaa tarkempi ja yksityiskohtaisempi.

RAG-mallien hyödyntäminen pienissä kielimalleissa tarjoaa useita etuja.

Se mahdollistaa pienempien ja resurssitehokkaampien mallien käytön monimutkaisten tehtävien suorittamiseen, sillä ulkoisen tiedon hyödyntäminen vähentää mallin tarvetta sisäisesti tallentaa suuria tietomääriä. Lisäksi, koska RAG-mallit voivat hyödyntää ajantasaisia tietokantoja, ne voivat tuottaa vastauksia, jotka heijastavat nykyhetken tietämystä ja ovat näin ollen relevantteja ja ajankohtaisia.

RAG-mallien käyttökohteet ovat moninaiset, ulottuen tiedonhakusovelluksista ja asiakaspalveluboteista henkilökohtaisiin avustajiin ja opetusalgoritmeihin. Niiden kyky yhdistää generatiivisen tekoälyn luovuus ja ulkoisten tietolähteiden tarkkuus avaa uusia mahdollisuuksia tekoälyn soveltamiseen, tehostaen ja rikastaen ihmisen ja koneen välistä vuorovaikutusta.

Pienten ja suurten kielimallien vertailu

Vertailtaessa pieniä ja suuria kielimalleja, erottuvat niiden väliset erot selkeästi käyttötarkoituksen, resurssivaatimusten ja käytettävyyden suhteen. Suuret kielimallit, kuten OpenAI:n GPT-3, tarjoavat laajan ymmärryksen luonnollisesta kielestä ja kyvyn suoriutua monenlaisista tehtävistä, aina kielikäännöksistä monimutkaiseen ongelmanratkaisuun. Näiden mallien valtava tietomäärä ja monipuolisuus tulevat kuitenkin korkealla resurssien kulutuksella, mikä voi rajoittaa niiden soveltuvuutta resurssirajoitteisissa ympäristöissä.

Toisaalta pienet kielimallit on suunniteltu erityisesti tiettyjä käyttötarkoituksia varten, mikä mahdollistaa niiden tehokkaamman toiminnan tietyissä konteksteissa. Ne vaativat vähemmän laskentatehoa ja tallennustilaa, mikä tekee niistä käyttökelpoisia laitteissa, joilla on rajoitetut resurssit, kuten älypuhelimet ja tabletit.

Pienet mallit voivat tarjota nopeita ja tarkkoja vastauksia erikoistuneissa tehtävissä, kuten asiakaspalvelubottien pyörittämisessä, luovassa kirjoittamisessa tai yksinkertaisissa tiedonhakutehtävissä.

Vaikka suuret kielimallit ovatkin monipuolisia ja kykenevät käsittämään monimutkaisia kielellisiä ilmiöitä, pienet mallit tarjoavat käytännöllisen vaihtoehdon, kun tavoitteena on nopeus, tarkkuus ja resurssitehokkuus. Lisäksi pienempien mallien käyttö voi vähentää ympäristövaikutuksia, sillä ne kuluttavat vähemmän energiaa koulutuksen ja käytön aikana. Tämä tekee niistä houkuttelevan valinnan yhä ympäristötietoisemmille yrityksille ja kehittäjille.

Pienet kielimallit mahdollistavat myös suuremman muokattavuude ja mukautuvuuden kehittäjille, jotka voivat räätälöidä malleja tiettyihin tarpeisiin. Tämä mukautuvuus, yhdistettynä niiden tehokkaampaan toimintaan rajoitetuissa ympäristöissä, asettaa ne vahvasti kilpailemaan suurten mallien kanssa erityisesti sovelluksissa, joissa kohdennettu suorituskyky on avainasemassa.

Täten, kun otetaan huomioon pienien ja suurten kielimallien väliset erot, päätöksenteossa tulisi ottaa huomioon projektin erityisvaatimukset, kohdeyleisö ja käytettävissä olevat resurssit. Tämä auttaa valitsemaan oikean mallin, joka parhaiten vastaa käyttötarkoitusta ja tarjoaa optimaalisen tasapainon suorituskyvyn ja resurssien käytön välillä.

Pienten kielimallien tulevaisuus

Pienten kielimallien tulevaisuus näyttää lupaavalta, kun tekoälyn kehitys etenee ja teknologian hyödyntämisen mahdollisuudet laajenevat.

Teknologiajättien, kuten Applen, Microsoftin, Metan ja Googlen, kasvava kiinnostus pieniin malleihin viittaa siihen, että niiden merkitys ja soveltuvuus erilaisiin käyttötarkoituksiin tulee vain kasvamaan.

Nämä yritykset ovat tunnustaneet pienempien mallien potentiaalin tarjota tehokkaita, mukautettavia ja resurssitehokkaita ratkaisuja tekoälyn alalla.

Yksi keskeinen tekijä, joka vaikuttaa pienten kielimallien tulevaisuuteen, on niiden kyky tarjota korkealaatuista suorituskykyä samalla, kun ne vastaavat yhä tiukempiin tietosuoja- ja yksityisyysvaatimuksiin. Pienempien mallien käyttö paikallisissa laitteissa mahdollistaa tietojen käsittelyn ilman, että niitä tarvitsee siirtää pilveen tai kolmannen osapuolen palvelimille, mikä lisää käyttäjien yksityisyyden suojaa. Esimerkiksi Applen tulevat tuotteet tulevat varmasti hyödyntämään mobiilipäätelaitteessa ajettavia pieniä kielimalleja.

Lisäksi, kun tekoälyteknologian kehitys etenee, pieniin kielimalleihin integroidaan yhä kehittyneempiä ominaisuuksia, kuten parempi kyky ymmärtää kontekstia ja tuottaa luonnollisempaa kieltä. Tämä parantaa niiden soveltuvuutta monenlaisiin sovelluksiin, mukaan lukien ääniavustajat, kielikäännökset ja henkilökohtaiset suositusjärjestelmät.

Tulevaisuudessa voidaan myös odottaa, että pienet kielimallit tulevat olemaan keskeisessä roolissa kehitettäessä tekoälysovelluksia, jotka toimivat reaaliajassa ja vaativat nopeaa tiedonkäsittelyä. Esimerkiksi älykkäät IoT-laitteet ja puettava teknologia hyötyvät suuresti pienempien mallien kyvystä toimia tehokkaasti rajoitetuilla laskentaresursseilla.

Edistys pienissä kielimalleissa ja niiden yhä laajempi käyttöönotto luo pohjan innovatiivisille sovelluksille ja palveluille, jotka voivat mullistaa tapamme vuorovaikuttaa teknologian kanssa.

Tämän kehityksen myötä tekoälyn hyödyt tulevat yhä useamman ulottuville, mikä edistää tekoälyn demokratisointia ja mahdollistaa sen positiivisen vaikutuksen yhteiskunnassa.

Pienten kielimallien tulevaisuus on siis kiinteästi sidoksissa niiden kykyyn vastata jatkuvasti muuttuviin teknologisiin haasteisiin ja yhteiskunnallisiin odotuksiin. Niiden jatkuva kehitys ja soveltaminen uusilla innovatiivisilla tavoilla varmistavat, että ne tulevat olemaan tärkeä osa tekoälyn ekosysteemiä tulevaisuudessa.

Kannattaa siis jäädä seuraamaan AI-Sanomia niin pysyt jatkuvasti kartalla eri kielimallien kehityksestä, käyttökohteista ja uusista innovaatioista!